近年、ありとあらゆるデータがデジタル化され、製造・流通・交通などのさまざまな実世界におけるデータ量が飛躍的に増大しています。こうした時々刻々と絶え間なく発生し続けるモノやヒトのデータを活用した新たなビジネスとして注目を集めるのがビッグデータです。

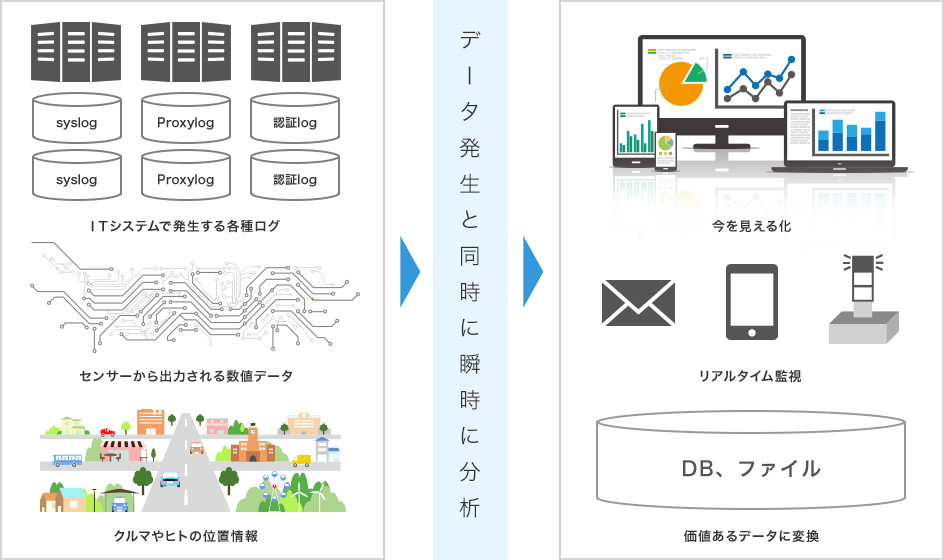

このビッグデータを処理するには、データベースに一旦ストック(蓄積)してからデータを集計・分析する従来のストック型データ処理では、今日のデータ量と質の変化に対応することができません。そこで、データの利活用サイクルに応じたデータ処理技術が求められるようになり、データが発生する度に逐次、データを集計・分析するフロー型のストリームデータ処理が誕生しました。

研究課題

このビッグデータ分野の一つとして、センサネットワークのように常に環境をモニタしながら逐次データを生成するシステムが多く存在します。このようなシステムでは、多数のデータ受信者が存在し、リアルタイムに独自のデータ解析を行っていますが、データの流れや集約・加工といった点に着目すると共通する部分が多く見受けられます。

そこで、ネットワークの有効利用の観点から、共通して必要なデータをネットワーク上の中継ノードで集約・加工をすることが望まれます。この課題を解決するために、データ処理のリアルタイム性を損なわないように、データ処理を行う中継ノードを適切に選ぶこととどのようなデータ処理を共通化するかの研究をしています。